Esta semana finalizou-se a aprovação do Regulamento europeu sobre inteligência artificial, vulgarmente conhecido como AI Act, depois de um longo processo de reflexão, discussão e negociação que atravessou quase todo este mandato do Parlamento Europeu.

A primeira pergunta que alguns nos fazem é a de saber porque decidimos regulamentar a inteligência artificial. Não seria suficiente a autorregulação pelas empresas?

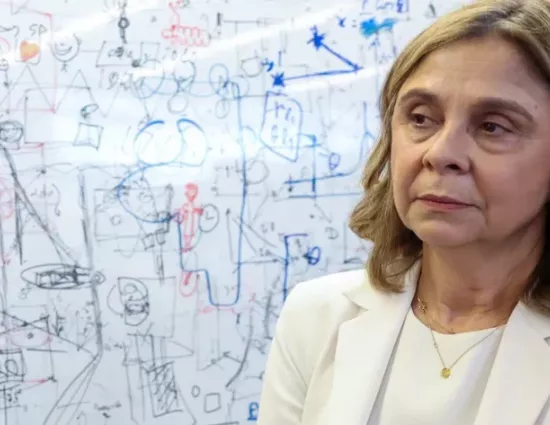

Como Carme Artigues, que dirigiu as negociações do lado do Conselho durante a presidência espanhola, referiu no recente Congresso da APDC em Lisboa, dedicado precisamente a este tema, regulamentamos a indústria de medicamentos porque não os desejamos ter à venda no mercado se não foram clinicamente testados. Regulamentamos a indústria automóvel porque não queremos que circulem carros pondo em risco a nossa segurança e a de terceiros. Por que razão, no caso de produtos ou serviços baseados em inteligência artificial, o risco deveria ficar totalmente do lado dos consumidores?

Alguém gostaria que a leitura de um tumor por uma máquina fosse insegura? Um falso positivo é tão mau quanto um falso negativo. Ou de não ter sido selecionado injustamente para um emprego? Ou ainda de ver o seu seguro de vida recusado sem justificação para isso?

Pior que isso, alguém gostaria de ser identificado como criminoso enquanto circulava tranquilamente numa estação de comboios por erro do sistema de identificação biométrica à distância em tempo real? Ou de as suas emoções serem levadas em consideração no seu local de trabalho, influenciando o seu salário?

Em sentido contrário, talvez todos estivéssemos disponíveis para contribuir com os nossos dados para que o tratamento do cancro fosse mais eficaz, para reduzir o insucesso escolar e para muitas outras vantagens de que podemos usufruir ao fazer bom uso desta tecnologia revolucionária.

Foi este equilíbrio entre riscos e oportunidades, entre prevenção de alguns riscos e os incentivos à inovação, que quisemos estabelecer neste regulamento, que é a primeira legislação do mundo sobre inteligência artificial.

O regulamento não tem como objeto a tecnologia em si, mas o seu uso, e estabelece regras diferentes consoante níveis de risco desses (abordagem baseada no risco).

Através dela pudemos garantir que a maior parte dos usos desta tecnologia têm obrigações bastante simples ou até nenhumas, e focar a nossa atenção, com obrigações mais exigentes, em usos que têm maior probabilidade de causar danos.

Assim, o regulamento divide os usos de inteligência artificial basicamente em três categorias: práticas de inteligência artificial proibidas, de risco elevado e de risco limitado.

Em primeiro lugar, as práticas de inteligência artificial proibidas, onde se incluem aplicações estritamente proibidas pelo seu risco inaceitável em termos de vigilância dos cidadãos ou para as suas liberdades fundamentais. Exemplos destes sistemas são a identificação biométrica remota em tempo real usada por autoridades policiais em espaços de acesso público (com algumas exceções); a manipulação cognitiva-comportamental; ou, ainda, o reconhecimento de emoções no local de trabalho e em estabelecimentos de ensino.

Em segundo lugar, são referidas as práticas de risco elevado, seguramente a parte mais detalhada e exigente deste regulamento. São aplicações que podem ser colocadas no mercado, mas que previamente têm de passar por uma avaliação de conformidade e cumprir uma longa lista de requisitos, garantindo que o sistema é seguro e confiável.

Além disso, para certo tipo de aplicações deverão ser realizadas avaliações de impacto nos direitos fundamentais. É o caso das aplicações que se relacionam com infraestruturas críticas, algumas aplicações de saúde ou algoritmos que visam selecionar pessoas para um emprego, um seguro de vida ou um crédito.

Em terceiro lugar, são referidos os usos de risco limitado, que diz respeito a sistemas de inteligência artificial para os quais são apenas exigidas obrigações de transparência como, por exemplo, um chatbot.

Por fim, foram ainda regulados os chamados modelos de inteligência artificial de finalidade geral que se tornaram conhecidos após o uso do Chat GPT. Como aqui não há um caso de uso específico (podem ser usados sem risco nenhum ou com risco elevado), poderemos ter meras obrigações de transparência ou requisitos mais rigorosos, como a mitigação dos riscos sistémicos e a garantia de um nível adequado de cibersegurança.

Como referi inicialmente, esta é apenas uma das vertentes do regulamento. A outra vertente, presente em muitas normas desta longa e complexa legislação (113 artigos e 13 anexos), é a inovação.

Prevê-se, por exemplo, a criação de sandboxes em todos os Estados-membros, ou seja, um ambiente de teste isolado, utilizado por programadores para testar novos programas, aplicativos e plataformas com segurança.

Além disso, há numerosas exceções para startups e PME de modo a facilitar a inovação.

Ainda assim, será preciso agora trabalhar muito bem as orientações de modo a “traduzir” os aspetos mais complexos deste regulamento, nomeadamente os requisitos exigidos a aplicações consideradas de alto risco. E, sobretudo, será indispensável promover a literacia em matéria de inteligência artificial de todos os que trabalham com ela e de todos os que a utilizam. São, por isso, tão importantes iniciativas como aquela que a APDC lançou a semana passada, designada “Impulso AI”, destinada a equipar profissionais de diferentes sectores com as competências necessárias para utilizarem devidamente a inteligência artificial.

Se os objetivos pretendidos neste regulamento serão ou não atingidos, só o futuro o dirá, quando avaliarmos a sua aplicação. Por ora, tentámos que a regulação fosse equilibrada e future-proof, ou seja, com capacidade para responder à evolução da tecnologia e dotada de flexibilidade, para se adaptar a ela.